Installation de Logstash

Dans cet article, nous allons poursuivre le déploiement de la solution, aujourd’hui, nous allons voir comment installer correctement Logstash; sera l’outil permettant de collecter les LOG et de les traiter avant de les stocker dans Elasticsearch.

Logstash s’occupe de la collecte, analyser et filtrer les journaux pour leur donner plus tard une sortie et les stocker dans une base de données. Nous travaillons avec différentes entrées ou types d’entrées, où nous pouvons indiquer ce que nous allons collecter, Tout type de bûche, du système, d’applications spécifiques, puis nous pouvons Filtrer par type de journal, si avec des erreurs seulement… nous les traiterons en fonction de notre besoin de les stocker enfin à travers des sorties ou des types de sorties, dans notre cas dans Elasticsearch. Par conséquent, nous aurons 3 Sections dans les paramètres à surveiller:

[Code source]Entrée {

...

}[/Code source]

D’où proviennent les informations? Nous pouvons utiliser des fichiers texte, Journaux d’applications ou de services, ainsi que toute application Beat que nous utilisons.

[Code source]filtre {

...

}[/Code source]

Décrivez ce que vous ferez avec chaque entrée de données, s’il faut les analyser ou les modifier ou ignorer certaines données, par exemple.

[Code source]sortie {

...

}[/Code source]

Indique où vous allez rediriger les données divulguées, Dans notre cas, nous utiliserons toujours la même chose, Recherche élastique

Nous allons voir dans une série de documents d’exemple comment utiliser Logstash pour analyser les journaux des serveurs Linux en tant qu’Apache, Événements de l’Observateur d’événements Windows, Journaux du pare-feu Fortigate… et comment avec les filtres, nous lirons les journaux dans des fichiers texte brut et nous pourrons convertir des données aussi intéressantes que les adresses IP en données de géolocalisation, pour obtenir leur position exacte et visualiser les données sur des cartes. Tout cela sans oublier que nous pouvons avoir une visualisation en temps réel ou consulter entre les périodes de rendez-vous.

Installer Logstash,

Comme tout outil de la pile, vous aurez besoin d’une machine virtuelle Java, nous installons donc OpenJDK et vérifions que nous avons l’installation correcte. D’ailleurs, si nous l’installons sur la même machine qu’Elasticsearch, cette exigence sera déjà remplie:

[Code source]apt-get install openjdk-8-jre-headless java -version[/Code source]

Pour installer, tout d’abord, nous téléchargeons et ajoutons la clé publique Elastic, et nous ajoutons le référentiel, nous mettons à jour la liste des paquets et procédons à l’installation de Logstash:

[Code source]wget -qO - https://artifacts.elastic.co/GPG-KEY-elasticsearch | Sudo apt-key add - ÉCHO &Quot;Deb https://artifacts.elastic.co/packages/6.x/apt principale stable&Quot; | tee -a /etc/apt/sources.list.d/elastic-6.x.list apt-get update apt-get install logstash[/Code source]

Pour vérifier que l’installation était correcte, avant de démarrer le service, nous pouvons exécuter le binaire et lui envoyer des exemples d’informations pour vérifier l’installation et que l’accès à Elasticsearch est correct. Avec cette configuration de base, nous allons le valider:

[Code source]cd /usr/share/logstash bin/logstash -e ' entrée { Puer { } } sortie { Recherche élastique { hôtes=&ÈRE;AMPÈRE;Gt; [&Quot;Direccion_IP_Elasticsearch:9200&Quot;] } }'[/Code source]

Quelques messages vont sortir et ensuite nous pouvons mettre un exemple de texte et cliquer sur le bouton [Entrer], Par ex:

[Code source]Bonjour! C’est un test![/Code source]

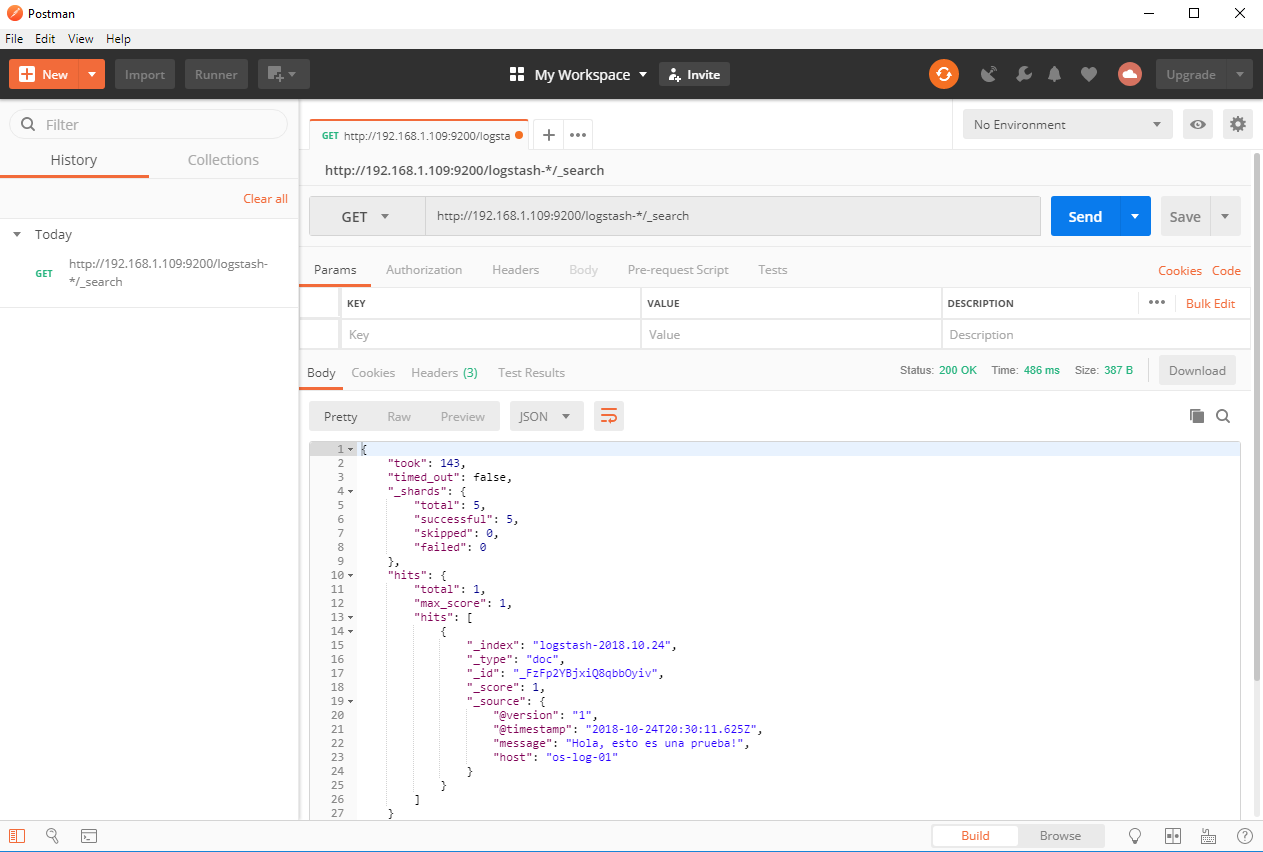

Télécharger Postman (Outil de diagnostic HTTP) De notre équipe, et nous faisons un GET pour récupérer tous les documents que vous trouvez dans l’index:

[Code source]HTTP://Dirección_IP_Elasticsearch:9200/logstash-*/_search[/Code source]

Nous appuyons sur SEND et nous voyons le résultat! Il y a un lien entre eux! 🙂

[Code source]Ctr+C[/Code source]

Nous allons maintenant être en mesure de lever le service Logstash et de lui permettre de démarrer automatiquement avec la machine!

[Code source]systemctl activer le service logstash logstash start[/Code source]

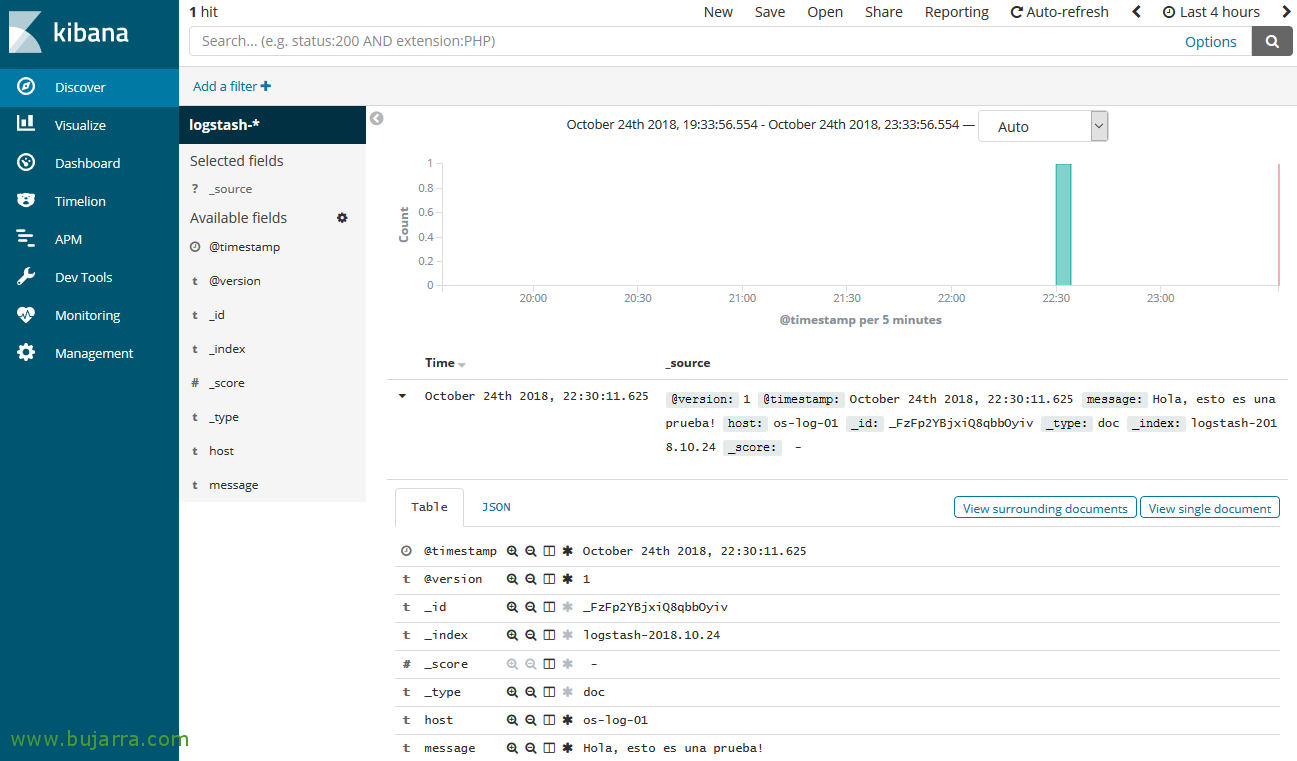

Création de l’index dans Kibana et visualisation des données,

Dans le prochain post, nous verrons l’installation de Kibana, Une fois que nous l’avons installé, nous serons en mesure de créer le motif des index Logstash et de visualiser les données.

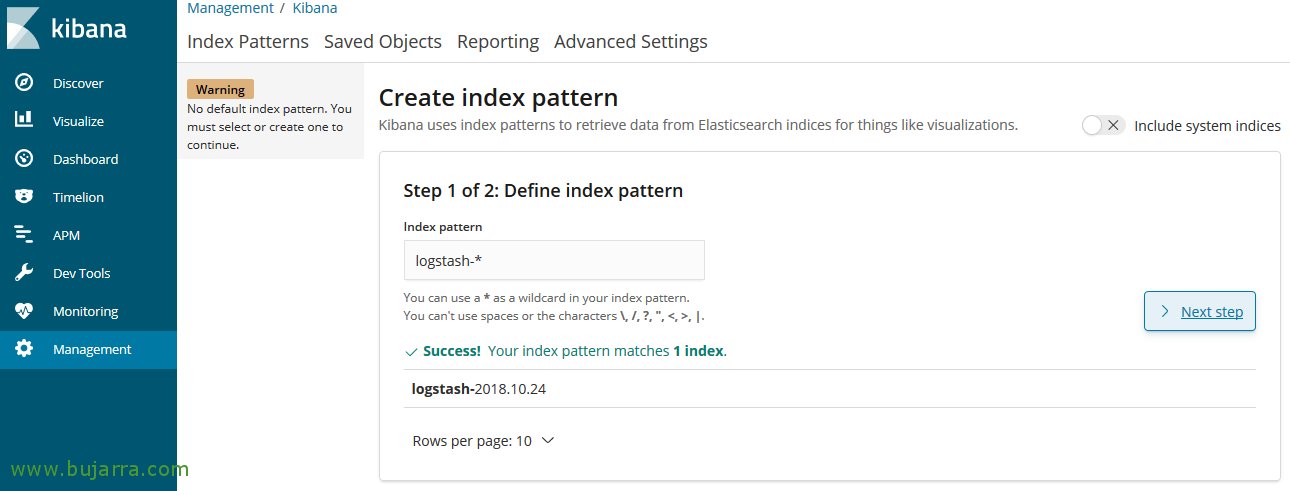

À Kibana, depuis “Gestion” > “Modèles d’indices” > “Créer un modèle d’index”, Dans le modèle, nous spécifions 'logstash-*', Et on continue avec l’assistant.

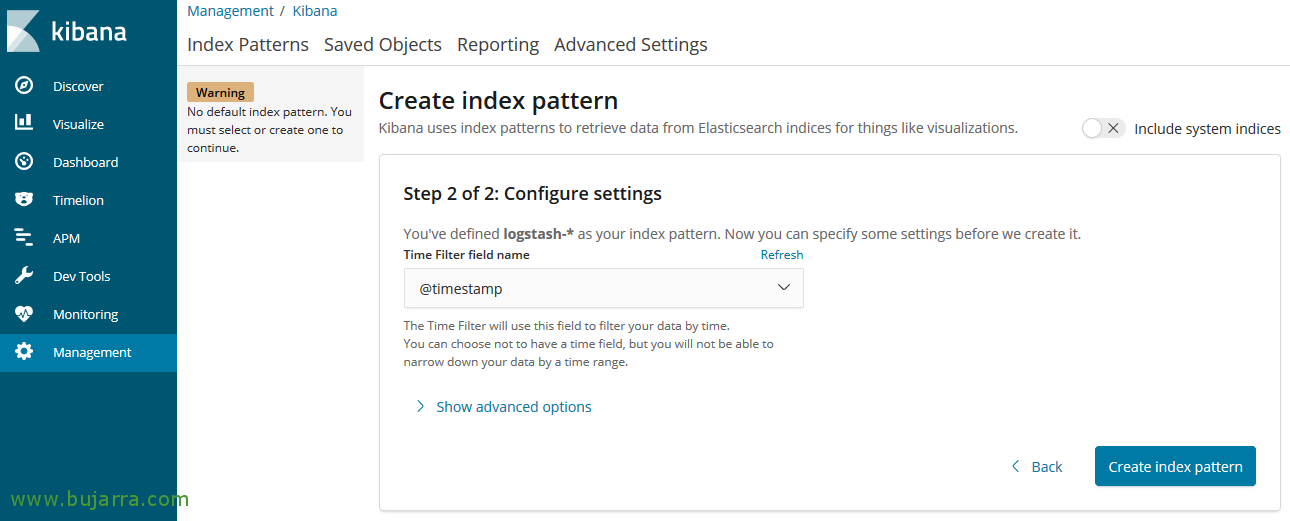

Sélectionnez le champ @timestamp comme pour le filtre temporisé, “Créer un modèle d’index”,

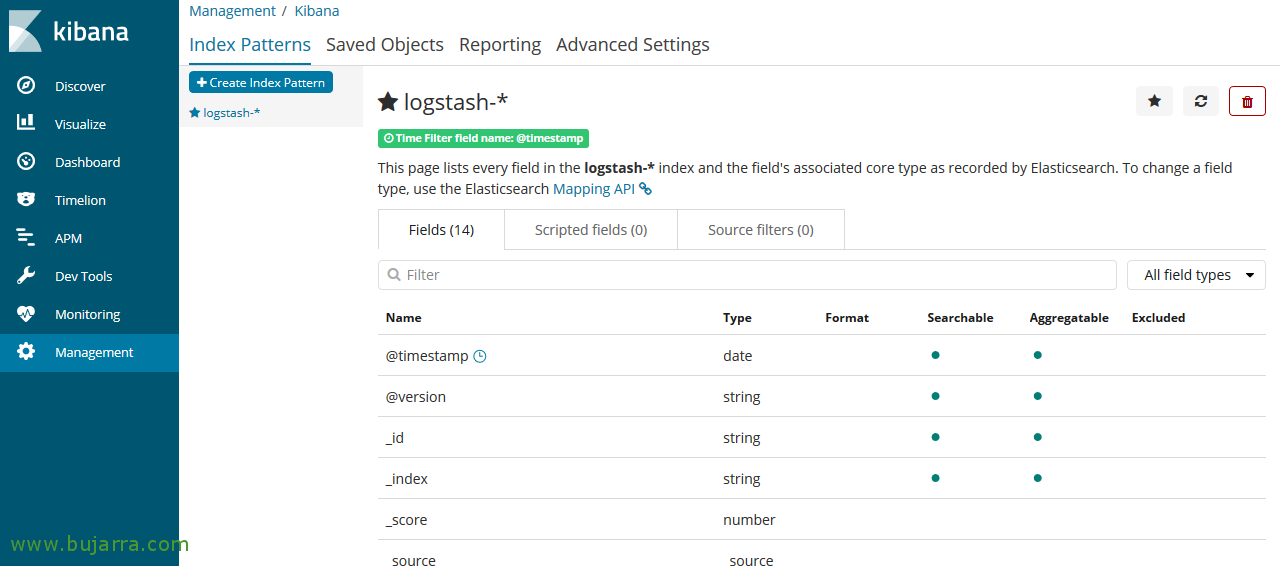

Nous avons déjà créé le modèle d’index, Nous pourrons voir ses champs et son type 🙂

Maintenant, Il n’y a plus qu’à aller à “Découvrir”, Sélectionnez notre index et jouez avec les dates et nous pourrons voir toutes les informations que nous avons stockées! Si tout s’est bien passé, nous aurons un seul enregistrement avec l’exemple que nous avons fait auparavant!!