Réplication entre deux EVA HP 4400 avec accès continu

Accès Continu, c'est la réplication native des baies HP StorageWorks Enterprise Virtual Array Family (EVA). Nous allons voir la configuration nécessaire tant au niveau du Switch de SAN qu'au niveau de Command View (CV) pour réaliser une réplication synchronisée ou asynchrone (selon les emplacements par exemple).

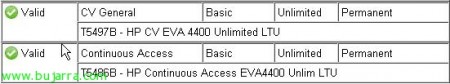

Je ne peux pas commencer sans mentionner qu'il est nécessaire d'avoir une licence spécifique pour réaliser ce type de réplication (selon les spécifications de votre EVA…), Je veux dire, si nous avons une licence de CV pour 4 To et que nous souhaitons les répliquer, nous devrons acquérir une licence d'Accès Continu de 4 To.

Dans mon cas: (licence illimitée autant dans CV que dans CA 🙂 )

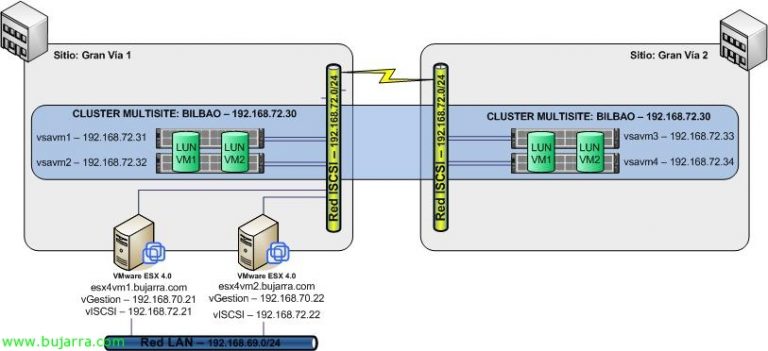

Cela dit, je vous présente l'environnement à configurer: deux CPD dans un même bâtiment (À, B) avec deux commutateurs en fibre dans chacun (11 et 12, 21 et 22). Dans chaque CPD, deux HP EVA's 4400 avec un seul groupe de disques (12HD 300Go de fibre); De plus,, un serveur qui servira de Command View dans chaque CPD (CV_A et CV_B) Et pour finir, une infrastructure de virtualisation répartie entre les deux CPD (4 ESX dans le CPD A et 2 ESX dans le CPD B, avec un seul vCenter sur le serveur CV_A. Tous les fibres vont par double chemin à l'exception des deux serveurs 'CV’ qui disposent d'un seul HBA.

Avec l'infrastructure présentée, la première chose que nous devons faire est de configurer correctement le zoning des commutateurs de fibre afin que les deux CV puissent voir la baie du CPD opposé. C'est une exigence pour effectuer la réplication; donc à la fin, nous disposerons de deux CV depuis lesquels nous pourrons gérer nos deux EVA.

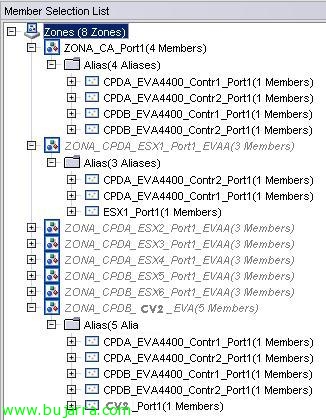

Dans le Switch 11 (le premier du CPD A), j'ai configuré les zones suivantes:

- ZONA_CA_Port1: C'est la zone qui contient les ports 1 des deux contrôleurs des deux EVA.

- ZONA_CPDA_ESX'x'_Port1_EVAA: C'est la zone qui contient le premier HBA de l'ESX1 avec accès aux ports 1 des deux contrôleurs de l'EVA du CPD A.

- ZONA_CPDB_CV2_EVA: C'est la zone où je donne des permissions au CV2 pour les ports 1 des deux contrôleurs des deux EVA.

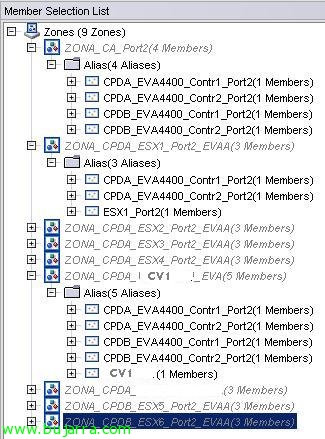

Dans le Switch 12 (le deuxième du CPD A), j'ai configuré les zones suivantes: (Ce commutateur est celui qui a le CV1 connecté)

- ZONA_CA_Port2: C'est la zone qui contient les ports 2 des deux contrôleurs des deux EVA.

- ZONA_CPDA_ESX'x'_Port2_EVAA: C'est la zone qui contient le deuxième HBA de l'ESX'x’ avec accès aux ports 2 des deux contrôleurs de l'EVA du CPD A.

- ZONA_CPDB_CV1_EVA: C'est la zone où je donne des permissions au CV1 pour les ports 2 des deux contrôleurs des deux EVA.

Dans le Switch 21 (le premier du CPD B), j'ai configuré les zones suivantes: (Ce commutateur est celui qui a le CV2 connecté)

- ZONA_CA_Port1: C'est la zone qui contient les ports 2 des deux contrôleurs des deux EVA.

- ZONA_CPDA_ESX'x'_Port1_EVAA: C'est la zone qui contient le premier HBA de l'ESX'x’ avec accès aux ports 1 des deux contrôleurs de l'EVA du CPD A.

- ZONA_CPDB_CV2_EVA: C'est la zone où je donne des permissions au CV2 pour les ports 2 des deux contrôleurs des deux EVA.

Dans le Switch 22 (le deuxième du CPD B), j'ai configuré les zones suivantes:

- ZONA_CA_Port2: C'est la zone qui contient les ports 2 des deux contrôleurs des deux EVA.

- ZONA_CPDA_ESX'x'_Port2_EVAA: C'est la zone qui contient le premier HBA de l'ESX'x’ avec accès aux ports 2 des deux contrôleurs de l'EVA du CPD A.

- ZONA_CPDB_CV1_EVA: C'est la zone où je donne des permissions au CV1 pour les ports 2 des deux contrôleurs des deux EVA.

Il faut mentionner, que l'idéal, permettra aux zones des ESX d'accéder aux ports de l'EVA du CPD B, ainsi si nous devions faire passer l'infrastructure pour travailler contre l'EVA du CPD B, nous aurions la moitié du travail fait.

Avec la configuration de zoning précédente, nous avons réussi à faire en sorte que les CV des deux CPDs soient capables de gérer les deux EVAs comme indiqué dans l'image.

La première chose que nous devrons configurer pour commencer à répliquer, est un groupe DR ou groupe de réplication de données. Dans ceux-ci, nous devrons regrouper les LUNs du même type; Dans mon cas, j'ai plusieurs LUN qui servent de DataStores dans VMware, donc je vais créer un seul DRGroup pour ces LUNs.

Pour ce faire,, nous cliquerons sur “Réplication de données” et “Créer un groupe de réplication de données”.

Dans la première partie, nous avons le nombre du DRG, le origine que toma por defecto es la EVA desde donde estas creando el grupo de replicación. Le destin, marcaremos la EVA a la que queremos replicar… como en mi caso solo tengo dos, no tengo posibilidad a fallo… Le Source Vdisk, es la LUN que deseamos replicar. (cada LUN solo puede estar en un DRGroup)

En la segunda parte, digamos que tenemos las opciones “avanzadas”:

- Write mode: Mode de escritura, sincrono o asincrono:

- Synchronous. This mode provides the best data protection. In synchronous write mode, the array acknowledges I/O completion after the data is cached on the source and destination arrays. This process maintains identical data on a source DR group and its destination DR group at all times.

- Asynchronous. This mode provides the best host I/O performance. In asynchronous write mode, le tableau source reconnaît les écritures de l'hôte avant que les données ne soient répliquées sur le tableau de destination. ce processus permet une I/O hôte plus rapide qu'en mode synchrone. d'un point de vue protection des données, il peut y avoir de brèves instances où les données ne sont pas identiques dans le groupe de reprise après sinistre source et destination. le mode d'écriture asynchrone peut être Basique ou amélioré, selon la version du logiciel du contrôleur.

- groupe de disques de destination: groupe de disques de destination. Dans mon cas, comme je n'ai qu'un seul châssis de disques par EVA, je n'ai qu'un groupe de disques.

- redondance de destination: nous pouvons modifier le niveau de RAID à destination ou le laisser comme à la source…

- accès hôte de destination: nous pouvons établir le niveau d'accès que la LUN aura…

- taille de log: taille de LOG. !!ATTENTION!! La taille de log par défaut à partir de la version du firmware 9.0.0 est originaire de 102,40GO. Les journaux sont stockés avec une redondance RAID1 et dans les deux baies, donc attention à l'espace disponible que vous avez.… Je l'ai fixé à 10240 Mo… ce qui me semble plus que suffisant.

- Groupe de disques de journal source: Le groupe de disques où les journaux sont stockés à l'origine. Cela pourrait être utile si nous avons deux groupes de disques avec différentes connexions. FIBRE contre FATA par exemple.

- Groupe de disques de journal de destination: Le groupe de disques où les journaux sont stockés à l'origine.

- Protection de secours sur membre non disponible: La protection des données de secours est une fonctionnalité qui bloque les E/S hôtes vers tous les disques virtuels dans un groupe DR lorsque des composants échouent ou deviennent indisponibles. Cette fonctionnalité protège les données en maintenant l'ordre d'écriture dans les groupes DR source et destination. (Il n'y a pas de meilleure explication)…

- Suspendre en cas de liens défaillants: Suspend la réplication si un lien est en état de défaillance..

- Suspendre lors d'une copie complète: Si ce sera ‘activé’ la réplication distante est suspendue lorsqu'une ‘copie complète’ est lancée.

- commentaires: Aucun commentaire…

une fois les options choisies, nous cliquerons sur “Créer” et commencera la première ‘copie complète’. Attention lorsque vous le lancez car cela peut affecter les performances du système…

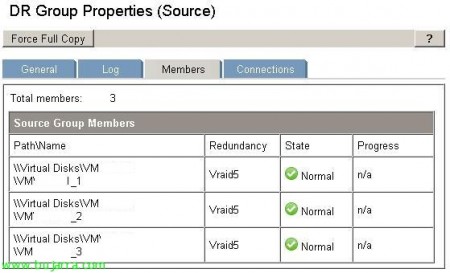

Une fois la première réplique créée et terminée, si nous avons sélectionné le mode d'écriture synchrone, elle sera en changement continu “origine-destination”. Néanmoins, en sélectionnant le DRGroup en question et en naviguant dans les onglets qui apparaissent dans l'image, nous pouvons à nouveau changer toutes les options qui sont données au moment de sa création. En plus de voir l'état de la réplique…

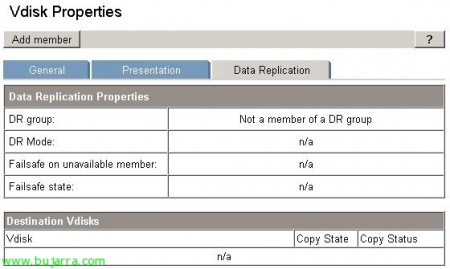

Si nous voulons ajouter un LUN à un DRGroup déjà créé, nous devrons le faire depuis les propriétés de la LUN sur l'onglet de DataReplication, Ajouter un membre.

- Groupe DR: Il nous permet d'indiquer un des DRG déjà créés

- Groupe de disques de destination: le groupe de disques de destination

- Niveau de redondance de destination: Le niveau de RAID à la destination.

Nous pourrions aussi depuis ici, sauter à créer un nouveau DRG, avec le bouton “Créer un groupe DR”…

C'est ainsi que s'affiche l'onglet Membres d'un DRGroup avec 3 LUNs en réplication.